Bất kỳ một trang web nào khi thiết lập cũng cần đến khối lượng dữ liệu khổng lồ. Vậy có cách nào để giúp các công cụ tìm kiếm có thể hiểu hết được những thông tin trên trang web đó. Lời giải đáp đó chính là sử dụng crawl data. Vậy bạn đã biết Crawl data là gì, lợi ích – hạn chế và cách thực hiện crawl dữ liệu như thế nào chưa? Nếu chưa, hãy đọc ngay những thông tin mà Viết Bài Xuyên Việt tổng hợp dưới đây, nhất là dân làm SEO thì càng không thể bỏ lỡ nhé!

Mục lục

Crawl data là gì?

Crawl data hay còn gọi là quét dữ liệu hay cào dữ liệu. Thuật ngữ này được sử dụng khá phổ biến và quen thuộc trong hoạt động SEO web thuộc lĩnh vực marketing online hay ngành công nghệ thông tin.

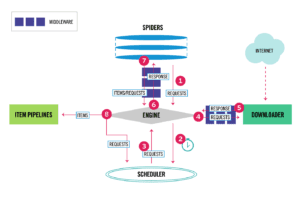

Kỹ thuật crawl dữ liệu có ý nghĩa rất quan trọng đối với website. Nó thực hiện việc thu thập dữ liệu từ một website nào đó rồi tổng hợp, phân tích và bóc tách thông tin theo yêu cầu mà người dùng đặt ra hay theo các dữ liệu mà công cụ tìm kiếm yêu cầu. Sau khi thực hiện xong, dữ liệu sẽ tự động lưu vào database.

Hiểu đơn giản, crawl dữ liệu là sử dụng phần mềm giúp bạn lấy thông tin của một website qua đường link web bạn nhập vào, sau đó phần mềm sẽ tự động thực hiện các phần còn lại để giúp việc lấy dữ liệu trên trang web đó dễ dàng hơn. Việc bạn crawl dữ liệu cũng tương tự như hoạt động của robots của các công cụ tìm kiếm (Google, Bing, Baidu,…) thường làm để phục vụ cho việc tìm kiếm.

Crawl dữ liệu thường áp dụng cho một số loại trang web như: web của các sàn thương mại điện tử, website rao vặt, website pháp luật đời sống, website nhật báo – tin tức hàng ngày, website bán hàng online, hay website vệ tinh – PBN. Và một số ngôn ngữ lập trình crawl data hữu hiệu hiện nay bao gồm: Python, PHP, Node.

TÌM HIỂU THÊM: Thẻ Hreflang Là Gì

Ưu điểm và hạn chế của việc crawl data

Nếu đã hiểu về cơ chế hoạt động của crawl data là gì, thì những thông tin về lợi ích và hạn chế của kỹ thuật này sẽ giúp ích cho bạn khá nhiều trong quá trình xây dựng Website.

Ưu điểm của crawl data

Những ưu điểm lớn nhất của việc thực hiện crawl data bao gồm:

- Giảm thiểu tối đa thời gian và công sức cho quá trình thu thập khối lượng lớn thông tin và dữ liệu.

- Giảm bớt lượng công việc mà người xây dựng content web cần sáng tạo. Việc crawl dữ liệu sẽ giúp trang web của bạn đa dạng và phong phú hơn lượng tin tức và nội dung, thu hút người dùng nhiều hơn.

- Thao tác thực hiện crawl data không quá phức tạp. Bạn có thể dễ dàng tổng hợp thông tin từ nhiều trang web khác nhau. Sau đó thực hiện đối chiếu, so sánh và làm các thuật toán để phân tích thị trường một cách sâu, tiết kiệm thời gian, công sức và hiệu quả hơn.

- Thông qua crawl data sẽ giúp bạn lấy thông tin nhanh chóng, chính xác và hữu hiệu.

Hạn chế của crawl data

Bên cạnh những ưu điểm kể trên thì việc crawl dữ liệu vẫn tồn tại những hạn chế, chẳng hạn như:

- Phần mềm dùng để crawl dữ liệu luôn tồn tại những rủi ro không thể tránh khỏi.

- Trường hợp website cần lấy thông tin thay đổi cấu trúc HTML thì bạn phải update, cập nhật để chương trình crawl phù hợp với thay đổi đó. Dù vậy, bạn cũng không nên quá đắn đo, lo lắng vì việc update thuật toán crawl cũng rất nhanh!

THÔNG TIN THÊM: NodeJS là gì

Hướng dẫn cách thực hiện crawl data trên Python

Để hỗ trợ tốt hơn cho hoạt động SEO web của bạn thì cách thực hiện crawl data là gì? Hãy cùng xem các bước hướng dẫn cách crawl dữ liệu với ngôn ngữ lập trình Python 3 như sau:

Bước 1. Bạn cài đặt thư viện (thư viện ở đây chính là newspaper) đã chứa dữ liệu sẵn qua pip: pip3 install newspaper3k

Bước 2.Tiếp theo, bạn sử dụng 5 dòng code dưới đây để lấy dữ liệu từ 1 URL bất kỳ:

- from newspaper import Article

- url = ‘XXX’ (XXX là đường link của website bạn đang cần lấy dữ liệu)

- article = Article(url)

- article.download()

- article.parse()

ĐỌC THÊM: Những lưu ý khi thiết kế layout website

Bước 3. Sau khi hoàn thành 2 bước trên, bạn chỉ cần chờ và lấy data về là xong: print(article.title)

Trong quá trình thực hiện, bạn có thể gặp phải một số khó khăn như: bị chặn request, bị block ip hay một số trang sẽ giới hạn request,… Hơn nữa, phương pháp này không áp dụng cho các trang tải dữ liệu dùng JS. Nếu bạn muốn thu thập data từ những trang web như thế, bạn cần sử dụng những phương pháp khác phù hợp hơn, có thể như: dùng Selenium hoặc tìm ra API của website đó,…

Tùy thuộc vào mỗi loại website mà chúng ta cần lựa chọn những kỹ thuật khác nhau. Hãy tìm hiểu chuyên sâu hơn về crawl data hoặc nhờ đến sự hỗ trợ từ những dịch vụ SEO web chuyên nghiệp để có thể thực hiện việc thu thập dữ liệu hoàn hảo nhất nhé!

XEM NGAY:

Kết luận

Trên đây là những thông tin cơ bản giới thiệu cho bạn crawl data là gì. Hy vọng qua bài viết, bạn đã hiểu hơn về lợi ích mà crawl data mang lại và đưa ra quyết định sử dụng nó hay không. Nếu bạn có những cách thực hiện crawl nào khác hay hơn, hữu ích hơn, hãy cùng chia sẻ với Viết Bài Xuyên Việt và mọi người cùng biết nhé! Chúc trang web của bạn luôn luôn hoạt động hiệu quả và thu hút nhiều người dùng hơn nhé!